Desmontando mitos de la inteligencia artificial

La inteligencia artificial (IA) se ha instalado en nuestras vidas. Los sistemas inteligentes deciden ofertas, gestionan publicidad, personalizan información, organizan contenidos multimedia privados o rastrean movimientos y relaciones sociales, y lo hacen todo de forma invisible e intencionadamente personalizada y dirigida a cada individuo. En otras ocasiones, se usan para decidir si mereces un préstamo, una subvención, un trabajo o, incluso, libertad condicional.

Se conocen muchas situaciones en las que estos sistemas pueden contribuir a la discriminación, manipulación y vigilancia de la sociedad. A veces de forma accidental por malas prácticas, y a veces con una intención clara de sacar provecho de esta potente tecnología para intereses espurios.

Quizás esto no sea más que el reflejo de la condición humana pero, a diferencia del humano, la IA es potencialmente más peligrosa debido a los siguientes factores: 1) la creencia de que una máquina no tiene prejuicios enmascara sus efectos discriminatorios; 2) la máquina no asume responsabilidades ni explica cómo trabaja; 3) tiene una alta escalabilidad que magnifica los resultados; y 4) la tecnología genera dependencia, lo cual crea una espiral que impide moderar su uso.

Es rara la semana que no recibimos noticias sobre vulneraciones de la protección de datos, proyectos de vigilancia masiva, alertas de software malicioso o desvelaciones de usos ilegítimos de esta tecnología por grandes corporaciones y gobiernos.

La manera más efectiva de contrarrestar esta tendencia es a través de la concienciación. Y para que la sociedad esté concienciada, debe estar primero bien informada y luego bien formada. Este video pretende contribuir a entender mejor la IA y sus posibles amenazas con el fin de despertar el interés y la conciencia de la sociedad sobre el futuro, que ya es presente.

Para ello, nos proponemos desmontar los siguientes cinco mitos de la IA:

- Mito 1: la IA es terriblemente compleja

- Mito 2: las máquinas inteligentes aprenden por sí mismas

- Mito 3: las decisiones con IA son más justas que las humanas

- Mito 4: todo funciona mejor con IA

- Mito 5: IA siempre ayuda al bien común

Otros videos aquí

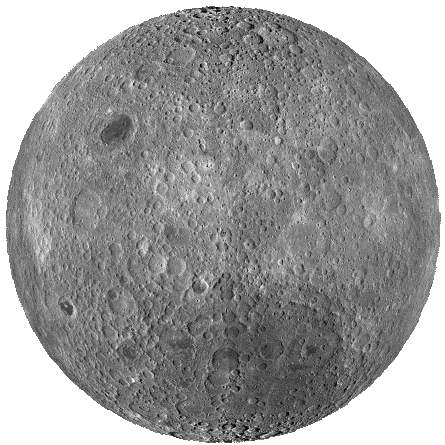

La cara oculta del big data: de la predicción a la manipulación social

Big data está viviendo un espléndido desarrollo. Las oportunidades que se ofrecen en inmensidad de aplicaciones de ingeniería, medicina, marketing o banca son interminables.

Sin embargo, el año 2018 ha sido muy convulso para el sector. Ha quedado constancia de los riesgos que subyacen por un mal uso de esta tecnología. Crece la inquietud sobre el impacto que las grandes empresas digitales están teniendo en la vida cotidiana. Mucho se habla de la protección del dato pero, ¿qué pasa con la opacidad del algoritmo? Ese que escoge el momento más vulnerable para venderte un producto, el que decide si una familia merece o no recibir un subsidio o el que interviene en unas elecciones democráticas.

La inteligencia artificial seguirá avanzando y aportando cosas maravillosas a la sociedad, pero deberá también limitarse a los valores de esa misma sociedad. En esta charla desvelo la cara oculta del big data como elemento de reflexión sobre el futuro de este campo o, lo que es lo mismo, el futuro de la sociedad.

Otros videos aquí

Lecturas imprescindibles

- Byung-Chul Han, La sociedad de la transparencia. Pensamiento Herder (2013)

- Safiya Umoja Noble, Algorithms of oppression: how search engines reinforce racism. NYU Press (2018)

- Cathy O’Neil, Armas de destrucción matemática. Capitán Swing Libros S.L. (2018)

- Scott Galloway, The Four: the hidden DNA of Amazon, Apple, Facebook, and Google. Portfolio Penguin (2017)

- Yuval Noah Harari, Homo Deus. Debate (2018)

Noticias y visualizados imprescindibles

- BBC—La democracia no está preparada para la era digital y está siendo destruida

- The Guardian—Do Google's 'unprofessional hair' results show it is racist?

- ProPublica—Machine Bias: There’s software used across the country to predict future criminals, and it’s biased against blacks

- TED—Zeynep Tüfekçi: Estamos construyendo una distopía solo para que la gente cliquee en los anuncios

- TED—Cathy O'Neil: La era de la fe ciega en los datos masivos ha de terminar

- TED—Scott Galloway: How Amazon, Apple, Facebook and Google manipulate our emotions

Otras lecturas y visualizados recomendables

- Byung-Chul Han, Psicopolítica. Pensamiento Herder (2014)

- Byung-Chul Han, Expulsión de lo distinto. Pensamiento Herder (2016)

- Sara Wachter-Boettcher. Technically wrong: sexist apps, biased algorithms, and other threats of toxic tech. WW Norton & Co (2017)

- Virginia Eubanks, Automating inequality: how high-tech tools profile, police, and punish the poor. Saint Martin's Press Inc. (2018)

- TED—Eli Pariser: Beware online "filter bubbles"

- The Guardian—Google is not ‘just’ a platform. It frames, shapes and distorts how we see the world

- The Wall Street Journal—How YouTube drives people to the Internet's darkest corners

- MIT—On Twitter, false news travels faster than true stories

- Science—Unique in the shopping mall: On the reidentifiability of credit card metadata

- Internet Health Report—Entendiendo las ‘noticias falsas’

- Nature—A 61-million-person experiment in social influence and political mobilization

- PNAS—Private traits and attributes are predictable from digital records of human behavior

- New York Times—How Trump consultants exploited the Facebook data of millions

- The Guardian—"I made Steve Bannon’s psychological warfare tool": meet the data war whistleblower

- El País—El Brexit no habría sucedido sin Cambridge Analytica

- Mozilla—A Scandal, a Napkin and the Health of the Internet

- The Economist—The techlash against Amazon, Facebook and Google, and what they can do

- Google duplex

Charlas dadas sobre este tema

- J. Casillas, Big data: ¿manipulación y/o predicción del comportamiento social?, Centro Mediterráneo, Universidad de Granada (May 16, 2018)

- J. Casillas, La cara oculta del big data: cuando la predicción da paso a la manipulación social, Instituto de la Paz y los Conflictos, Universidad de Granada (October 3, 2018)

- J. Casillas, Dándole vueltas al big data, Ayuntamiento de Otura, Otura, Granada (October 18, 2018)

- J. Casillas, La cara oculta del big data: de la predicción a la manipulación social, ISDI (Instituto Superior para el Desarrollo de Internet), Madrid (January 10, 2019)

Juego sucio y malas prácticas en inteligencia artificial

La Inteligencia Artificial (IA) está consiguiendo grandes avances en casi cualquier sector gracias a la capacidad de automatizar procesos y ganar eficiencia y escalabilidad. Pero no todo es éxito, hay multitud de ejemplos donde la IA ha creado desigualdades incorporando sesgos de género, raza o clase social debido al uso de malas prácticas o diseños deficientes. Al menos esto suele ser involuntario porque, lamentablemente, en otras ocasiones, la inteligencia artificial se utiliza como verdadero juego sucio para favorecer intereses políticos o económicos. En esta charla repasamos varios casos recientes, algunos todavía activos, de la cara fea de la IA.

All that glitters is not gold in artificial intelligence; welcome to its dark side

Artificial Intelligence (AI) is achieving great advances in almost any sector thanks to the ability to automate processes and gain efficiency and scalability. But not everything is successful, there are many examples where AI has created inequalities incorporating biases of gender, race or social class due to the use of bad practices or deficient designs. At least this is usually involuntary because, sadly, on other occasions AI is used as a real foul play to favor political or economic interests. In fact, apart from discrimination, AI is also used for manipulation and surveillance. In this talk we review several recent cases, some still active, of the ugly face of AI.

More videos here

Lecturas recomendadas / Recommended readings

- Yuval Noah Harari, 21 lecciones para el siglo XXI. Debate (2018)

- Paloma Llaneza, Datanomics. Deusto (2019)

- José Ignacio Latorre, Ética para máquinas. Planeta (2019)

- Bloomberg—Amazon Doesn’t Consider the Race of Its Customers. Should It?

- Actionable Auditing: Investigating the Impact of Publicly Naming Biased Performance Results of Commercial AI Products

- Venture Beat—MIT researchers: Amazon’s Rekognition shows gender and ethnic bias

- Reuters—Amazon scraps secret AI recruiting tool that showed bias against women

- Prediction-Based Decisions and Fairness: A Catalogue of Choices, Assumptions, and Definitions

- Quartz—Prescription AI: The algorithm will see you now

- Mic—'Minority Report' Is Real, And It's Really Reporting Minorities

- Nature—The spread of low-credibility content by social bots

- SSRN—Bots, #Strongerin, and #Brexit: Computational Propaganda During the UK-EU Referendum

- CNN—When seeing is no longer believing. Inside the Pentagon’s race against deepfake videos

- The Guardian—The tyranny of algorithms is part of our lives: soon they could rate everything we do

- Telegraph—China's 'social credit' system bans millions from travelling

- Privacy International—Secret Global Surveillance Networks: Intelligence Sharing Between Governments and the Need for Safeguards

- Make “Fairness by Design” Part of Machine Learning

- Tutorial on fairness in machine learning

- Vishal Maini, Samer Sabri, Machine Learning for Humans (2017)

- M. Brundage et al., The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation (2018)

Visualizados recomendados

- You Won’t Believe What Obama Says In This Video! ;-)

- Anisa Sanusi & Henry Hoffman Face-Swap

- Everybody Dance Now

- Black Mirror (3x01) Caída en Picado

- China Foils Toilet Paper Thieves With Facial Recognition Tech | CNA Insider

- China Behavior Rating System V/S Sweden Microchip implants | Must watch technology

- Exposing China's Digital Dystopian Dictatorship | Foreign Correspondent

Webs recomendadas

- Awful AI—Listado de software de inteligencia artificial dañino (discriminación, desinformación, vigilancia...)

- Fairness, Accountability, and Transparency in Machine Learning

- Snopes

- Politifact

- FactCheck

- Big Brother Watch

Charlas dadas sobre este tema

- J. Casillas, Juego sucio y malas prácticas en inteligencia artificial, Centro Mediterráneo, Universidad de Granada (March 6, 2019)

- J. Casillas, All that glitters is not gold in Artificial Intelligence; welcome to its dark side, 29th Conference of the European Association for Research on Services (RESER), Ceuta, Spain (September 13, 2019)

Miedos y esperanzas para el sector sociosanitario en la era del big data

Big data está revolucionando el paradigma con el que se abordan muchos problemas, y entre ellos está el sector sociosanitario. En esta charla veremos algunas de las soluciones que estamos desarrollando para diagnóstico del Alzheimer, eficiencia energética en hospitales, o reconocimiento de tumores.

Pero big data no solo son luces, también tiene sombras. Así, antes de ver sus beneficios, estudiaremos algunos casos donde big data genera discriminación. Porque sí, un algoritmo también "puede ser" machista y racista.

Otros videos aquí

Lecturas recomendadas

- Quartz—Prescription AI: The algorithm will see you now

- Tutorial on fairness in machine learning

- Shira Mitchell, Eric Potash, Solon Barocas, Prediction-Based Decisions and Fairness: A Catalogue of Choices, Assumptions, and Definitions, arxiv.org/abs/1811.07867, Nov. 2018

- E. Ruiz, J. Ramírez, J.M. Górriz, J. Casillas, Alzheimer's disease computer-aided diagnosis: histogram-based analysis of regional MRI volumes for feature selection and classification, Journal of Alzheimer's Disease 65:3 (2018) 819-842. ISSN 1387-2877. DOI: 10.3233/JAD-170514

- G. Kalogeras, S. Rastegarpour, C. Koulamas, A.P. Kalogeras, J. Casillas, L. Ferrarini, Predictive capability testing and sensitivity analysis of a model for building energy efficiency, Building Simulation (2019) In press. ISSN 1996-3599.

- GastroView - CTA https://www.youtube.com/watch?v=kuiMoXEmkRo

Charlas dadas sobre este tema

- J. Casillas, Miedos y esperanzas para el sector sociosanitario en la era del big data, Centro de Estudios de Postgrado, Universidad de Jaén (March 14, 2019)